Softsign Ableitung Rechner

Online Rechner für die Derivative der Softsign-Funktion

Geben Sie das Argument (x) ein und klicken Sie auf Berechnen um die Ableitung der Softsign-Funktion zu ermitteln. Die Softsign-Ableitung ist fundamental für die Backpropagation in neuronalen Netzen und hat ihr Maximum bei x=0 mit dem Wert 1.

💡 Softsign Ableitung

\(\text{softsign}'(x) = \frac{1}{(1 + |x|)^2}\)

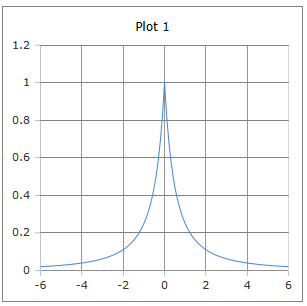

Die glockenförmige Kurve der Softsign-Ableitung mit Maximum bei x=0

Die Softsign-Ableitung verstehen

Die Ableitung der Softsign-Funktion ist von zentraler Bedeutung für die Backpropagation in neuronalen Netzen. Sie hat eine charakteristische glockenförmige Kurve mit ihrem Maximum bei x=0 und dem Wert 1. Die Formel softsign'(x) = 1/(1+|x|)² zeigt, dass die Ableitung immer positiv ist und sanfter abfällt als die Tanh-Ableitung, was zu stabileren Gradienten führen kann.

📈 Grundformeln

Verschiedene Darstellungen:

📊 Eigenschaften

- • Maximum: softsign'(0) = 1

- • Symmetrisch um x=0

- • Glockenförmige Kurve

- • Immer positiv: softsign'(x) > 0

🔬 Anwendungen

- • Backpropagation-Algorithmus

- • Gradientenberechnung

- • Optimierung neuronaler Netze

- • Sanfte Gradientenflüsse

⭐ Vorteile

- • Sanfterer Abfall als Tanh'

- • Numerisch stabil

- • Einfache Berechnung

- • Keine Nullstellen

Mathematische Herleitung

📈 Ableitung der Softsign-Funktion

Schritt-für-Schritt Herleitung:

\[\text{Gegeben: } \text{softsign}(x) = \frac{x}{1 + |x|}\] \[\text{Fallunterscheidung für } |x|:\] \[\text{Fall 1: } x \geq 0 \Rightarrow \text{softsign}(x) = \frac{x}{1 + x}\] \[\frac{d}{dx}\left(\frac{x}{1 + x}\right) = \frac{(1+x) \cdot 1 - x \cdot 1}{(1+x)^2} = \frac{1}{(1+x)^2}\] \[\text{Fall 2: } x < 0 \Rightarrow \text{softsign}(x) = \frac{x}{1 - x}\] \[\frac{d}{dx}\left(\frac{x}{1 - x}\right) = \frac{(1-x) \cdot 1 - x \cdot (-1)}{(1-x)^2} = \frac{1}{(1-x)^2}\]

🔄 Vereinheitlichung

Kompakte Form der Ableitung:

\[\text{Für } x \geq 0: \text{softsign}'(x) = \frac{1}{(1+x)^2} = \frac{1}{(1+|x|)^2}\] \[\text{Für } x < 0: \text{softsign}'(x) = \frac{1}{(1-x)^2} = \frac{1}{(1+|x|)^2}\] \[\text{Vereinheitlicht: } \text{softsign}'(x) = \frac{1}{(1+|x|)^2}\] \[\text{Verifikation: Kontinuierlich bei } x = 0\]

📊 Charakteristische Werte

Wichtige Punkte der Softsign-Ableitung:

\[\text{Maximum bei } x = 0: \quad \text{softsign}'(0) = \frac{1}{(1+0)^2} = 1\] \[\text{Symmetrie: } \text{softsign}'(-x) = \text{softsign}'(x)\] \[\text{Asymptotik: } \lim_{x \to \pm\infty} \text{softsign}'(x) = 0\] \[\text{Halbwertspunkte: } \text{softsign}'(\pm 1) = \frac{1}{4} = 0{,}25\]

Praktische Berechnungsbeispiele

📝 Beispiel 1: Backpropagation-Schritt

Aufgabe: Gradientenberechnung in neuronaler Schicht

Gegeben: Aktivierung a = softsign(1.5) ≈ 0.6, Fehler δ = 0.2

Berechnung:

\[\text{Softsign-Wert: } \text{softsign}(1{,}5) = \frac{1{,}5}{1 + 1{,}5} = \frac{1{,}5}{2{,}5} = 0{,}6\] \[\text{Ableitung: } \text{softsign}'(1{,}5) = \frac{1}{(1 + 1{,}5)^2} = \frac{1}{(2{,}5)^2} = \frac{1}{6{,}25} = 0{,}16\] \[\text{Gradient: } \frac{\partial E}{\partial z} = \delta \cdot \text{softsign}'(1{,}5) = 0{,}2 \cdot 0{,}16 = 0{,}032\]

Backpropagation: Sanfterer Gradient im Vergleich zu Tanh

📝 Beispiel 2: Vergleich mit Tanh-Ableitung

Aufgabe: Vergleich der Ableitungen bei verschiedenen Eingaben

Szenario: Gradientenverhalten bei extremen Werten

Berechnung:

\[\text{Bei } x = 3:\] \[\text{Softsign': } \text{softsign}'(3) = \frac{1}{(1+3)^2} = \frac{1}{16} = 0{,}0625\] \[\text{Tanh': } \tanh'(3) = 1 - \tanh^2(3) \approx 1 - (0{,}995)^2 \approx 0{,}01\] \[\text{Verhältnis: } \frac{\text{softsign}'(3)}{\tanh'(3)} \approx \frac{0{,}0625}{0{,}01} = 6{,}25\]

Vorteil: Softsign-Ableitung fällt langsamer ab → weniger Vanishing Gradients

📝 Beispiel 3: Optimale Gewichtsinitialisierung

Aufgabe: Xavier-Initialisierung für Softsign

Ziel: Gradienten in optimaler Größenordnung halten

Berechnung:

\[\text{Erwartete Ableitung bei } x = 0: E[\text{softsign}'(0)] = 1\] \[\text{Varianz der Ableitung: } \text{Var}(\text{softsign}'(x)) \text{ hängt von Eingabeverteilung ab}\] \[\text{Xavier für Softsign: } \sigma_W^2 = \frac{1}{n_{in}} \text{ (angepasst für Maximum 1)}\] \[\text{Resultat: Stärkere Gradienten als bei Tanh/Sigmoid}\]

Praxis: Weniger aggressive Initialisierung nötig als bei sättigenden Funktionen

Vergleich mit anderen Ableitungen

📊 Ableitungsvergleich-Tabelle

| x | softsign'(x) | tanh'(x) | σ'(x) (Sigmoid) | ReLU'(x) |

|---|---|---|---|---|

| -3 | 0.063 | 0.010 | 0.045 | 0 |

| -1 | 0.250 | 0.420 | 0.197 | 0 |

| 0 | 1.000 | 1.000 | 0.250 | - |

| 1 | 0.250 | 0.420 | 0.197 | 1 |

| 3 | 0.063 | 0.010 | 0.045 | 1 |

Backpropagation-Details

🔄 Gradientenfluß durch Schichten

Rückwärtspropagation mit Softsign-Ableitung:

\[\text{Forward Pass: } z^{(l)} = W^{(l)}a^{(l-1)} + b^{(l)}, \quad a^{(l)} = \text{softsign}(z^{(l)})\] \[\text{Backward Pass: } \delta^{(l)} = \frac{\partial E}{\partial z^{(l)}}\] \[\text{Kettenregel: } \delta^{(l-1)} = (W^{(l)})^T \delta^{(l)} \odot \text{softsign}'(z^{(l-1)})\] \[\text{Gewichts-Update: } \frac{\partial E}{\partial W^{(l)}} = \delta^{(l)} (a^{(l-1)})^T\]

📈 Vorteil gegenüber Tanh

Warum Softsign-Ableitung vorteilhaft sein kann:

\[\text{Langsamerer Abfall: } \text{softsign}'(x) = \frac{1}{(1+|x|)^2} \text{ vs. } \tanh'(x) = 1-\tanh^2(x)\] \[\text{Bei } |x| = 2: \text{softsign}'(2) = \frac{1}{9} \approx 0{,}111 \text{ vs. } \tanh'(2) \approx 0{,}071\] \[\text{Bei } |x| = 3: \text{softsign}'(3) = \frac{1}{16} = 0{,}0625 \text{ vs. } \tanh'(3) \approx 0{,}01\] \[\text{Resultat: Weniger Vanishing Gradients in tiefen Netzen}\]

Implementierung und Code

💻 Code-Implementierungen

Effiziente Berechnung der Softsign-Ableitung:

Python (NumPy):

def softsign_derivative(x):

return 1 / ((1 + np.abs(x)) ** 2)

# Wenn softsign bereits berechnet:

def softsign_derivative_from_output(softsign_out):

# softsign(x) = x/(1+|x|) => |x| = |softsign_out|/(1-|softsign_out|)

abs_out = np.abs(softsign_out)

return (1 - abs_out) ** 2

# Backpropagation implementieren:

def backward_pass(delta, x):

return delta * softsign_derivative(x)

TensorFlow:

# Automatische Differentiation

with tf.GradientTape() as tape:

y = tf.nn.softsign(x)

dy_dx = tape.gradient(y, x)

⚡ Optimierte Backpropagation

Praktische Implementation für neuronale Netze:

Vollständige Layer-Implementation:

class SoftsignLayer:

def forward(self, x):

self.input = x

self.output = x / (1 + np.abs(x))

return self.output

def backward(self, grad_output):

# Verwendet gespeicherte Eingabe

softsign_grad = 1 / ((1 + np.abs(self.input)) ** 2)

return grad_output * softsign_grad

# Verwendung in Training-Loop:

grad_input = layer.backward(grad_from_above)

🎯 Praktische Tipps

Optimierung der Softsign-Ableitung in der Praxis:

\[\text{✓ Numerisch stabil für alle Eingabewerte}\] \[\text{✓ Keine speziellen Grenzfälle zu behandeln}\] \[\text{✓ Einfache Berechnung ohne Exponentialfunktionen}\] \[\text{✓ Vektorisierung effizient möglich}\] \[\text{✓ Gradientenclipping meist nicht nötig}\]

Anwendungen in verschiedenen Bereichen

🧠 Neuronale Netze

- • Backpropagation-Algorithmus

- • Stabilere Gradienten

- • Alternative zu Tanh-Ableitung

- • Weniger Vanishing Gradients

📊 Optimierung

- • Gradientenabstieg

- • Adam, RMSprop Optimierer

- • Lernraten-Anpassung

- • Momentum-basierte Verfahren

🔬 Forschung

- • Gradient-Flow-Analyse

- • Aktivierungsfunktions-Studien

- • Theoretische Untersuchungen

- • Vergleichende Analysen

⚙️ Hardware-Implementierung

- • FPGA-freundliche Berechnung

- • Low-Power-Designs

- • Quantisierte Netze

- • Edge-Computing

💡 Wichtige Eigenschaften der Softsign-Ableitung:

- Glockenform: softsign'(x) = 1/(1+|x|)² mit Maximum bei x=0

- Immer positiv: Keine negativen Gradienten möglich

- Sanfter Abfall: Langsamere Sättigung als Tanh-Ableitung

- Numerisch stabil: Einfache Berechnung ohne kritische Bereiche

🔬 Anwendungsgebiete der Softsign-Ableitung:

- Backpropagation: Grundlage für Gradientenberechnung in NN

- Optimierung: Gewichtsaktualisierung durch Gradientenabstieg

- Stabilität: Weniger Vanishing Gradients als bei Tanh

- Hardware: Einfache Implementation in FPGA/ASIC

acos - Arkuskosinus

acot - Arkuskotangens

acsc - Arkuskosekans

asec - Arkussekans

asin - Arkussinus

atan - Arkustangens

atan2 - Arkustangens von y/x

cos - Kosinus

cot - Kotangens

csc - Kosekans

sec - Sekans

sin - Sinus

sinc - Kardinalsinus

tan - Tangens

hypot - Hypotenuse

deg2rad - Grad in Radiant

rad2deg - Radiant in Grad

Hyperbolik

acosh - Arkuskosinus hyperbolikus

asinh - Areasinus hyperbolikus

atanh - Arkustangens hyperbolikus

cosh - Kosinus hyperbolikus

sinh - Sinus hyperbolikus

tanh - Tangens hyperbolikus

Logarithmus

log - Logarithmus zur angegebene Basis

ln - Natürlicher Logarithmus zur Basis e

log10 - Logarithmus zur Basis 10

log2 - Logarithmus zur Basis 2

exp - Exponenten zur Basis e

Aktivierung

Softmax

Sigmoid

Derivate Sigmoid

Logit

Derivate Logit

Softsign

Derivate Softsign

Softplus

Logistic

Gamma

Eulersche Gamma Funktion

Lanczos Gamma-Funktion

Stirling Gamma-Funktion

Log Gamma-Funktion

Beta

Beta Funktion

Logarithmische Beta Funktion

Unvollstaendige Beta Funktion

Inverse unvollstaendige Beta Funktion

Fehlerfunktionen

erf - Fehlerfunktion

erfc - komplementäre Fehlerfunktion

Kombinatorik

Fakultät

Semifakultät

Steigende Fakultät

Fallende Fakultät

Subfakultät

Permutationen und Kombinationen

Permutation

Kombinationen

Mittlerer Binomialkoeffizient

Catalan-Zahl

Lah Zahl